Introduction à la panne Cloudflare du 18 novembre 2025

Le 18 novembre 2025 restera une date marquante dans l’histoire de l’infrastructure Internet mondiale. Ce jour-là, une panne significative a affecté Cloudflare, une plateforme essentielle qui assure la performance, la sécurité et la disponibilité de nombreux sites et services sur la Toile. Cet incident, bien que temporaire, a provoqué une interruption considérable du trafic web, impactant des millions d’utilisateurs et plusieurs services couplés. Cet article propose une analyse complète des causes, des mécanismes en jeu, des dégâts occasionnés ainsi que des mesures prises pour éviter une nouvelle Cloudflare outage.

Déroulement et impact de l’incident

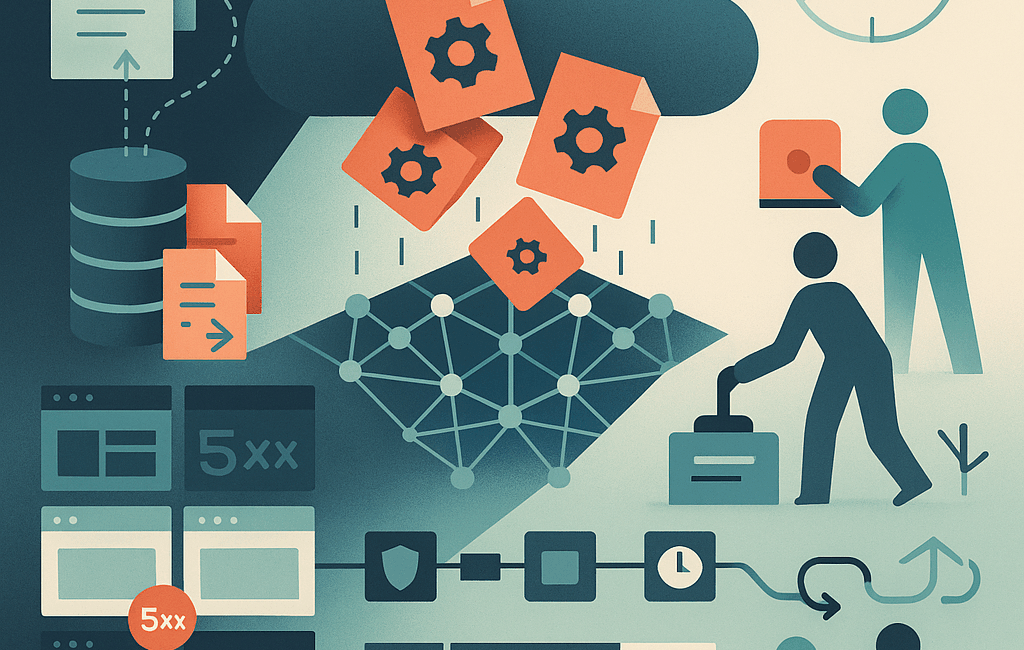

À partir de 11h20 UTC, le réseau de Cloudflare a rencontré des graves difficultés de traitement du trafic essentiel, provoquant progressivement l’apparition généralisée d’erreurs 5xx HTTP sur les sites hébergés. Initialement, les équipes techniques ont suspecté une attaque DDoS à grande échelle. Néanmoins, il s’est avéré que la source du problème était interne : une modification inadéquate des permissions dans le système de bases de données ClickHouse a entraîné la production et la diffusion d’un fichier de configuration doublé en taille pour le système de gestion des bots.

Cette surcharge a dépassé la limite mémoire allouée à ce fichier critique dans les modules de routage de trafic, provoquant des arrêts et redémarrages répétés. Par conséquent, plusieurs services interconnectés, notamment le CDN principal, le système Turnstile pour la gestion des accès, Workers KV et le tableau de bord administratif ont été perturbés, générant une cascade d’erreurs sur le réseau.

Services affectés en détail

- Core CDN et sécurité : erreurs HTTP 5xx généralisées, impactant la disponibilité des contenus web et la réponse des serveurs.

- Turnstile : impossibilité de chargement sur les pages de connexion, bloquant certains accès utilisateur.

- Workers KV : hausse significative des erreurs dues à l’échec des requêtes vers le proxy central.

- Dashboard : bien que partiellement fonctionnel, l’accès a été limité pour une majorité d’utilisateurs en raison de l’indisponibilité de Turnstile.

- Sécurité Email : perturbations temporaires dans la détection de spam, sans impact critique.

- Access : échecs d’authentifications généralisés, empêchant les utilisateurs d’atteindre leurs applications.

Analyse technique et cause racine

Cloudflare traite chaque requête via un chemin précis, impliquant diverses couches et modules, dont un proxy central nommé “Frontline” qui applique les politiques clients. La gestion des bots repose sur un fichier de configuration régulièrement actualisé employant des données issues d’un modèle de machine learning. Ce fichier, généré toutes les cinq minutes via des requêtes sur la base ClickHouse, contenait suite à une modification inhabituelle nombre de doublons, faisant brutalement augmenter sa taille.

Ce changement provient d’une mise à jour visant à rendre explicite l’accès aux tables sous-jacentes dans la base ClickHouse afin d’affiner la gestion des permissions sur les requêtes distribuées. Malheureusement, cette évolution a multiplié les entrées dans le fichier, excédant les capacités prévues par le système de gestion des bots.

Mécanismes de limitation et défaillance

Pour préserver la performance et l’allocation mémoire, chaque module de proxy préalloue un certain nombre de ressources. Le système bot management dispose d’une limite fixée à 200 fonctionnalités utilisées simultanément. Avec le fichier doublé en taille dépassant cette limite, le service a déclenché une erreur fatale non gérée (« panic »), entraînant des erreurs HTTP 5xx massives.

Réactions et mesures d’atténuation

Dès la détection, l’équipe a mis en œuvre plusieurs actions : suspension de la propagation des nouveaux fichiers problématiques, rétablissement d’une configuration fonctionnelle antérieure et redémarrage progressif des services impactés. Par ailleurs, un contournement temporaire a été appliqué sur Workers KV et Access pour minimiser l’incidence sur les autres services critiques.

La situation a commencé à se normaliser dès 14h30 UTC et une remise en service complète a été réalisée à 17h06 UTC après un nettoyage intégral des états erronés.

Leçons tirées et perspectives d’amélioration

Cette Cloudflare outage est la plus grave depuis 2019, rappelant les défis majeurs que posent la maintenance d’une infrastructure critique à l’échelle mondiale. À la suite de cet événement, plusieurs axes vont être renforcés :

- Robustification des mécanismes d’ingestion et validation des fichiers de configuration automatiques.

- Mise en place de kill switches globaux pour désactiver rapidement des fonctionnalités en cas d’anomalie.

- Prévention des risques de saturation des ressources système par des rapports d’erreurs ou dumps mémoire.

- Révision exhaustive des modes de défaillance des modules proxy pour améliorer leur résilience.

Cloudflare réaffirme son engagement pour un Internet plus sécurisé, plus rapide et plus fiable, conscient que l’interruption d’aujourd’hui doit nourrir les innovations de demain, notamment grâce aux avancées en intelligence artificielle qui transforment rapidement les infrastructures numériques.

Conclusion

La panne du 18 novembre 2025 a relié plusieurs leçons sur la complexité et la fragilité des écosystèmes numériques modernes. Grâce à une analyse rapide et des interventions ciblées, la continuité du service a pu être rétablie. La communauté des passionnés de technologie et des professionnels de la création digitale peut ainsi continuer à bâtir sur des plateformes renforcées, intégrant les dernières avancées en termes de sécurité et d’intelligence artificielle.

Pour approfondir votre compréhension ou envisager une carrière dans cet univers en constante mutation, n’hésitez pas à explorer les nombreuses opportunités offertes via les réseaux Cloudflare et les domaines liés à la cybersécurité.